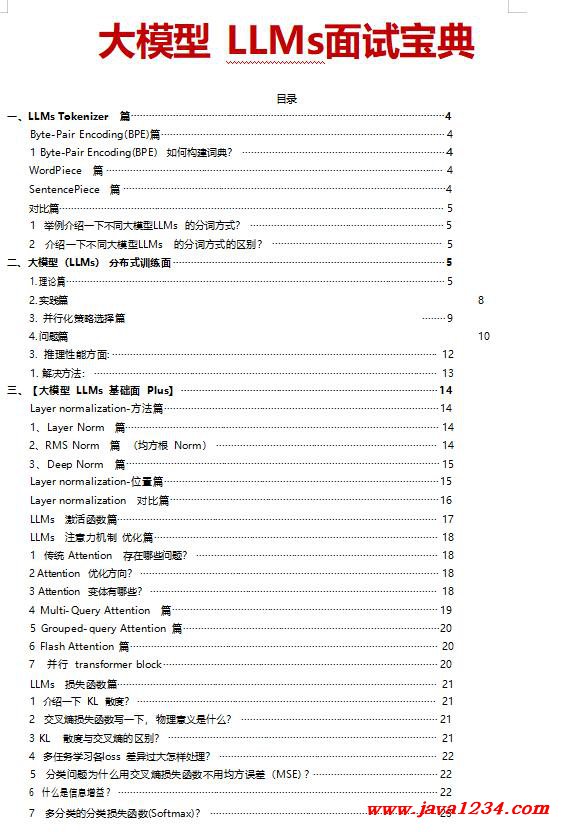

| Õż▒µĢłķōŠµÄźÕżäńÉå |

|

Õż¦µ©ĪÕ×ŗLLMSķØóĶ»ĢÕ«ØÕģĖ DOC õĖŗĶØ▓

ĶĮ¼ĶØ▓Ķ欒╝Ühttp://www.python222.com/article/1271

ńøĖÕģ│µł¬ÕøŠÕQ?/strong>

õĖ╗Ķ”üÕåģÕ«╣ÕQ?/strong> Byte-Pair Encoding(BPE)Įŗ?/strong>

1 Byte-Pair Encoding(BPE) Õ”éõĮĢµ×äÕŠÅĶ»ŹÕģĖÕQ?/strong> 1 ÕćåÕżćŁæø_ż¤ńÜäĶ«ŁŠlāĶ»Łµ¢?õ╗źÕÅŖµ£¤µ£øńÜäĶ»ŹĶĪ©Õż¦×«Å’╝ø 2 ׫åÕŹĢĶ»ŹµŗåÕłåõžōÕŁŚń¼”Š_ÆÕ║”(ÕŁŚń▓ÆÕ║?ÕQ?“qČÕ£©µ£½Õ░ŠµĘšdŖĀÕÉÄń╝Ć“”ÕQ?Šl¤Ķ«ĪÕŹĢĶ»ŹķóæńÄć 3 ÕÉłÕŲłµ¢╣Õ╝Å:Šl¤Ķ«Īµ»ÅõĖĆõĖ¬Ķ┐׊l?ńøöRé╗ÕŁŚĶŖéÕ»╣ńÜäÕć║ńÄ░ķóæńÄćÕQ?׫嵣Ćķ½śķóæńÜäĶ┐׊lŁÕŁŚĶŖéÕ»╣ÕÉłÕŲłõĖ║µ¢░ÕŁŚĶ»ŹÕQ?/span> 4 ķćŹÕżŹĮW?nbsp;3 µŁź’╝ī ńø┤Õł░Ķ»ŹĶĪ©ĶŠæųł░Ķ«æų«ÜńÜäĶ»ŹĶĪ©Õż¦×«?µł¢õĖŗõĖĆõĖ¬µ£Ćķ½śķóæÕŁŚĶŖéÕ»╣Õć║ńÄ░ķóæńÄćõžō 1ŃĆ?nbsp;µ│©’╝Ü GPT2 ŃĆüBART ÕÆ?nbsp;LLaMA ׫▒ķććńö©õ║åBPEŃĆ?/span>

Word Piece Įŗ?/strong>

Word Piece õĖ?/strong> BPE Õ╝éÕÉīńéęÄ(gu©®)ś»õ╗Ćõ╣ł’╝¤ µ£¼Ķ┤©õĖŖĶ┐śµś»BPE ńÜäµĆصā│ŃĆéõĖÄBPE µ£ĆÕż¦Õī║Õł½Õ£©õ║?Õ”éõĮĢķĆēµŗ®õĖżõĖ¬ÕŁÉĶ»ŹśqøĶĪīÕÉłÕŲł BPE µś»ķĆēµŗ®ķóæµ¼Īµ£ĆÕż?nbsp;ńÜäńøĖķéšdŁÉĶ»ŹÕÉł“qė×╝ø Word Piece ĮÄŚµ│ĢķĆēµŗ®ĶāĮÕż¤µÅÉÕŹćĶ»ŁĶ©Ćµ©ĪÕ×ŗµ”éńÄćµ£ĆÕż¦ńÜäńøöRé╗ÕŁÉĶ»ŹśqøĶĪīÕÉłÕŲłÕQ?nbsp;µØźÕŖĀÕģźĶ»ŹĶĪ©’╝ø µ│©’╝Ü BERT ķććńö©õ║?nbsp;Word PieceŃĆ?/span>

SentencePiece Įŗ?/strong>

ĮÄĆÕŹĢõ╗ŗŠlŹõĖĆõĖ?/strong> SentencePiece µĆØĶĄ\ÕQ?/strong> µŖŖń®║µĀķg╣¤ÕĮōõĮ£õĖĆ┐UŹńē╣īDŖÕŁŚĮW”µØźÕżäńÉåÕQīÕåŹńö©BPE µł¢ĶĆģµØźµ×äķĆĀĶ»Źµ▒ćĶĪ©ŃĆ?nbsp;µ│©’╝ÜChatGLM ŃĆüBLOOM ŃĆ?nbsp;PaLM ķććńö©õ║åSentencePieceŃĆ?/span>

|

ĶŗÅÕģ¼Š|æÕ«ēÕż?32061202001004ÕÅ?/p>

ĶŗÅÕģ¼Š|æÕ«ēÕż?32061202001004ÕÅ?/p>